Fundamentos de la incertidumbre en las mediciones

Esta página de conocimientos responde a preguntas sobre el significado, la relevancia, el impacto, la determinación y el cálculo de la incertidumbre de medida. En este contexto, recibirá información sobre el coeficiente de sensibilidad y el balance/presupuesto de incertidumbre de la medición.

Caja con anclajes:

- ¿Qué significa la incertidumbre de la medición?

- Relación entre: Precisión, exactitud y resolución

- ¿Por qué es relevante la incertidumbre de la medición?

- ¿Cuál es el efecto de la incertidumbre de la medición en el contexto de la calibración?

- ¿Cómo se determina y calcula la incertidumbre de la medición?

- ¿Qué significa la incertidumbre de la medición según la GUM?

- Principios estadísticos para el cálculo de la incertidumbre de la medición

- ¿Qué significa el coeficiente de sensibilidad en el contexto de la incertidumbre de medición?

- ¿Qué es un balance de incertidumbre de la medición/presupuesto de incertidumbre de la medición?

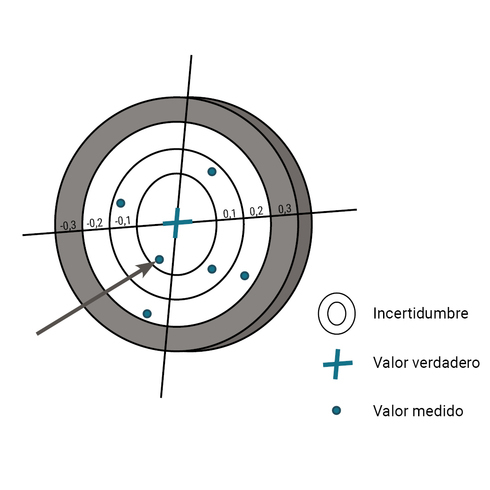

¿Qué significa la incertidumbre de la medición?

Las mediciones no proporcionan valores absolutamente exactos, ya que siempre están sujetas a imperfecciones que no se pueden cuantificar con precisión. Así, el resultado de una medición depende del método de medición aplicado, de las condiciones ambientales como la temperatura, la humedad y la presión ambiental, del rendimiento de la técnica de medición utilizada (desplazamiento, deriva) y de la competencia del técnico de calibración.

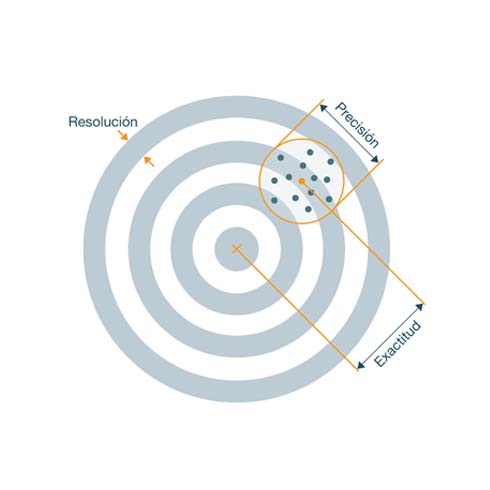

Relación entre: Precisión, exactitud y resolución

Se entiende que la resolución es la unidad de recuento más pequeña, en este caso la distancia entre los anillos del objetivo. La dispersión de los agujeros de bala indica la precisión, es una medida de la reproducibilidad de los impactos. La dispersión de los agujeros de bala hacia el centro del blanco se expresa mediante la precisión. (Sólo se tienen en cuenta las desviaciones sistemáticas)

¿Por qué es relevante la incertidumbre de la medición?

Para evaluar y seguir utilizando el resultado de una medición, debe hacerse una declaración sobre la calidad del resultado, además del valor estimado determinado del mensurando. La indicación de la incertidumbre de la medición refuerza la confianza en los resultados de las mediciones y permite la comparación de diferentes mediciones. Se trata de un requisito básico en el intercambio nacional e internacional de mercancías. También hay otras razones para tratar la incertidumbre de la medición; por ejemplo, si la medición forma parte de una calibración y debe figurar en el certificado de calibración, o si debe evaluarse el cumplimiento de la especificación de precisión de un instrumento de medida. "¡Un valor medido sin incertidumbre de medición no es un resultado de medición completo!"

¿Cuál es el efecto de la incertidumbre de la medición en el contexto de la calibración?

Durante la calibración, se comprueba si el sensor cumple con la precisión especificada. La desviación encontrada deberá ser inferior a la desviación permitida. Sin embargo, la calibración en sí misma, como cualquier medición, está sujeta a la incertidumbre. Esto se da en la forma de la incertidumbre de la medición. La incertidumbre de la medición se compone principalmente de las influencias de error del operario, del elemento de ensayo, del método y de la referencia. La incertidumbre de la medición es una medida de la dispersión aleatoria del resultado de la medición y, por tanto, se indica con + /-. Debe incluirse en la evaluación de la conformidad, según la norma de decisión.

¿Cómo se determina y calcula la incertidumbre de la medición?

La determinación de la incertidumbre de la medición suele realizarse según el procedimiento descrito. Las magnitudes de influencia individuales Xi se describen según su distribución como funciones de probabilidad u(Xi), compensadas con las sensibilidades asociadas del modelo de medición Y = f(Xi) y combinadas mediante el método de adición cuadrática a una incertidumbre de medición estándar u(Y). La incertidumbre de medición estándar u(Y) es la medida de la dispersión de la medición. Para expresar un rango de valores en el que se encuentra el verdadero valor medido con una probabilidad que suele ser del 95%, la incertidumbre de medición del nivel se multiplica por un factor de cobertura. En la mayoría de los casos se aplica una distribución normal. El multiplicador corresponde al valor numérico 2.

¿Qué significa la incertidumbre de la medición según la GUM?

La "Guía para la Expresión de la Incertidumbre en la Medición", abreviada como GUM, se considera la norma mundialmente aceptada para la evaluación y especificación de las incertidumbres de medición y ha sido adoptada por varias organizaciones internacionales. La GUM sigue el enfoque de declarar cada resultado de medición como la mejor estimación de un mensurando con la incertidumbre de medición asociada. Así, el método GUM proporciona un procedimiento de evaluación claramente definido para realizar la descripción de la tarea de medición y los rangos de variabilidad de las magnitudes relevantes utilizando distribuciones de probabilidad y ecuaciones de modelos. Así, con la ayuda del método GUM se puede mostrar de forma transparente qué correlaciones se utilizan para la determinación de la incertidumbre de medición y cómo se considera la estimación de las magnitudes implicadas.

Principios estadísticos para el cálculo de la incertidumbre de la medición

En general, la experiencia metrológica demuestra que los procesos de medición no pueden controlarse con tanta precisión y las condiciones de medición no pueden especificarse con tanta exactitud como para poder asignar un único valor a un mensurando. Por lo tanto, la solución radica en describir el conocimiento incompleto mediante distribuciones de valores cuyo peso se estima. El conocimiento más o menos exacto de los valores tolerables de una cantidad medible se describe mediante distribuciones de los valores posibles. La densidad de probabilidad determina el peso que se da a un valor Y de tamaño X en función de los conocimientos disponibles. Para poder realizar posteriormente el correspondiente cálculo de la incertidumbre de la medición, son necesarios los fundamentos del cálculo de probabilidades o de la estadística:

Funciones de distribución, como:

- Distribución rectangular, trapezoidal, triangular, en forma de campana (curva de campana de Gauss).

Otros parámetros estadísticos, como

- Media aritmética, rango, desviación estándar, propagación de errores

¿Qué significa el coeficiente de sensibilidad en el contexto de la incertidumbre de la medición?

El coeficiente de sensibilidad ci describe la medida en que el valor estimado de la variable de salida se ve influido por los cambios en el valor estimado de la variable de entrada. Puede determinarse a partir de la función del modelo mediante ecuaciones o métodos numéricos.

¿Qué es un balance de incertidumbre de la medición?

El análisis de la incertidumbre de una medición -a menudo denominado balance de la incertidumbre de la medición- debe incluir una lista de todas las fuentes de incertidumbre durante la medición, junto con las incertidumbres de medición estándar asociadas y una indicación de cómo se han determinado. En el caso de las observaciones que se repiten más de una vez, debe indicarse también el número n de observaciones realizadas.